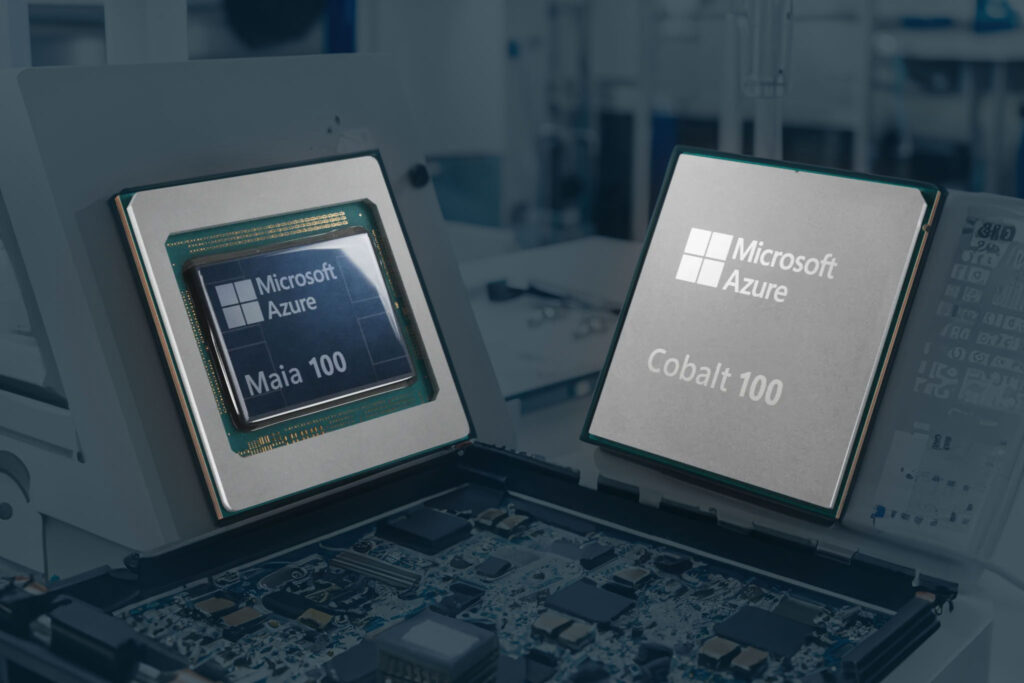

Lange wurde darüber spekuliert, nun ist es offiziell: Microsoft entwickelt eigene Chips, um die KI-Fähigkeiten seiner Azure Cloud auf ein neues Level zu heben. Die ersten beiden Prozessoren – Azure Maia und Azure Cobalt – wurden speziell für KI-Workloads bzw. allgemeine Cloud-Dienste entwickelt. Sie sollen 2024 auf den Markt kommen.

Keine Zeit alles zu lesen? TL;DR!

Microsoft hat seine ersten eigenen Chips für die Azure Cloud angekündigt:

- Azure Maia ist ein KI-Chip für Training und Inferencing

- Azure Cobalt ein ARM-basierter Cloud-Prozessor

- Ziel ist mehr Unabhängigkeit von Drittanbietern wie Nvidia

- Erste Maia/Cobalt-Server kommen 2024

Hintergrund: Der KI-Chip-Hunger ist enorm

Microsoft’s Interesse an eigenen Chips kommt nicht von ungefähr. Der Bedarf an leistungsfähigen KI-Chips, insbesondere GPUs, ist in den letzten Jahren explodiert. Große Sprachmodelle wie GPT-3 fressen enorme Rechenleistung und benötigen Tausende von Hochleistungs-GPUs.

Bisher ist der Grafikkarten-Hersteller Nvidia hier klarer Marktführer. Doch die massiven Investitionen von Microsoft, Google und Co in KI-Forschung machen eigene Chips immer attraktiver. Zudem können so Lieferengpässe umgangen werden.

Laut Microsoft soll die Entwicklung schon 2017 begonnen haben. Man habe die Cloud-Infrastruktur von Grund auf für die KI-Ära neu erdacht, so Rani Borkar von Microsoft.

Azure Maia – KI-Beschleuniger mit Wasserkühlung

Der Azure Maia 100 Chip ist speziell auf KI-Workloads wie Training und Inferencing von großen KI-Modellen zugeschnitten.

Mit 105 Milliarden Transistoren auf 5nm-Chips von TSMC ist Maia ein echtes Monstrum. Zum Vergleich: Nvidias H100 GPU kommt auf 80 Milliarden Transistoren.

Wassergekühlte KI für maximale Leistung

Maia ist der erste wassergekühlte Server-Chip von Microsoft. Dies ermöglicht eine besonders hohe Packungsdichte für maximale Leistung und Energieeffizienz. Die Wasserkühlung erlaubt laut Microsoft auch den Einsatz in bestehenden Rechenzentren ohne aufwendige Umbauten.

MX Datenformate für schnellere KI

Microsoft hat für Maia eine Unterstützung für sub-8-bit MX Datenformate implementiert. Dies soll das Training und Inferencing von KI-Modellen beschleunigen.

Microsoft arbeitet hier im Open Compute Project mit anderen Tech-Riesen wie AMD, Intel und Nvidia zusammen, um neue MX-Standards für KI-Chips zu etablieren.

Erste Tests mit GPT-3

Azure Maia wird bereits intensiv von Microsoft und Partnern wie OpenAI getestet. Unter anderem laufen Trainings des GPT-3.5 Sprachmodells, auf dem ChatGPT basiert, auf den neuen Chips.

Laut OpenAI ermöglichen es die Maia Chips, leistungsfähigere KI-Modelle kostengünstiger zu trainieren und so neue Anwendungen zu ermöglichen.

Azure Cobalt – Cloud-Prozessor mit 128 ARM-Kernen

Bei Cobalt handelt es sich um einen 128-Core ARM-basierten Prozessor, der Cloud-Dienste wie Microsoft Teams oder SQL-Server beschleunigen soll.

Laut Microsoft ist Cobalt bis zu 40% schneller als die bisherigen ARM-Chips in der Azure Cloud. Durch feingranulare Kontrolle von Power- und Performance-Einstellungen pro Kern und VM soll Cobalt sehr flexibel einsetzbar sein.

Und wie geht es weiter?

Mit Maia und Cobalt geht Microsoft einen wichtigen Schritt in Richtung mehr Unabhängigkeit von Drittanbietern wie Nvidia oder Intel.

Insbesondere der auf KI zugeschnittene Maia Chip könnte ein Game Changer sein und Microsoft einen Wettbewerbsvorteil verschaffen.

Die kommenden 1-2 Jahre werden zeigen, ob Microsofts Eigenentwicklungen mit Marktgrößen wie Nvidia und AMD mithalten können. Der große Vorteil: Microsoft kann die Chips eng an die Azure Cloud Architektur anpassen.

Spannend bleibt, ob Microsoft die Chips mittelfristig auch als Standalone-Produkte verkaufen wird oder ob sie Azure-exklusiv bleiben.